Vidéo Naviguer sur le site Web de Statistique Canada

Numéro de catalogue : 11-629-x

Numéro d'exemplaire : 2019002

Date de diffusion : Le 12 décembre 2019

Naviguer sur le site Web de Statistique Canada - Transcription vidéo

(Le symbole de Statistique Canada, le mot-symbole « Canada » et le titre : « Naviguer sur le site Web de Statistique Canada » apparaissent à l'écran.)

(Image de fond representation de graphique sur lequel apparaisent les mots : Naviguer sur le site Web de Statistique Canada, présenté par Jérémie Darrieu, agent de diffusion)

On veut vous souhaiter la bienvenue au webinaire sur la navigation du site Web de Statistique Canada.

Dans la présentation d'aujourd'hui, nous vous montrerons comment notre site Web récemment mis à jour peut être utilisé. Tout au long du webinaire, nous verrons ensemble les principales fonctionnalités du site et nous vous montrerons comment accéder aux informations. Donc, à la suite de la présentation, vous serez en mesure de naviguer notre site efficacement.

Je vais maintenant partager mon écran pour que vous puissiez voir notre page d'accueil. Donc au www.statcan.gc.ca.

(L'écran deviant blanc. Les mots suivants (en Anglais) apparaisent sur l'écran : There is no content to view at the moment either because no content is being shared or because an unsupported media object is being shared.)

(L'écran d'acceuil de Statistique Canada apparaît)

Donc, avec 25 millions d'utilisateurs de données chaque année, Statistique Canada a reconnu qu'il était nécessaire d'avoir un site plus simple, plus cohérent et plus convivial.

Donc, le site Web a été mis à jour le 4 juin dernier, pour avoir une apparence plus conforme aux autres sites du Gouvernement du Canada. Des sites gouvernementaux que vous pouvez toujours accéder dans l'onglet dans le coin supérieur à la droite de notre bannière bleue.

(L'écran se déplace vers le haut de l'écran et le pointeur survole les onglets pour sujet, données, analyse, référence, enquêtes et programmes statistiques, à propos et Canada.ca.)

Donc aujourd'hui nous allons surtout apprendre à naviguer le site Web à partir des principaux onglets ici. Vous pouvez naviguer par sujets, par données, par produits analytiques, par référence, par géographie, par programme de recensement et par enquêtes et programmes statistiques. Mais avant de rentrer dans les détails, je vais vous présenter les fonctionnalités de la page d'accueil que vous puissiez avoir une idée des produits que nous offrons.

(Le pointeur se déplace vers l'hyperlien pour Mon Statcan.)

Alors tout d'abord, vous avez la bande bleue avec nos différents onglets. Et vous avez juste ici dans le coin à droite, quelque chose qui s'appelle « Mon Statcan ». C'est enfin un portail d'information sur lequel vous pouvez vous s'inscrire, et vous pouvez choisir des sujets d'information et vous abonnez à ces sujets. et vous abonnez à ces sujets. Et vous recevrez des notifications par courriel lorsque de nouvelles publications seront mises à jour. Donc une façon très appropriée d'avoir des nouvelles informations sur des sujets précis.

(Le pointeur se déplace vers la gauche.)

Ensuite, au centre de la page, sur le côté gauche, vous avez notre section « En manchette » et « Le Quotidien ».

En manchette va vous presenter une série d'articles qui ont été publiées dans les derniers jours concernant différentes enquêtes et différents sujets. Vous avez en total de 4 articles qui sont présentées ici. Vous pouvez continuer la lecture en allant directement sur l'article en question.

(L'écran passe à la page d'accueil pour Le Quotidien)

Vous avez également Le Quotidien qui est notre bulletin de diffusion officiel de Statistique Canada depuis 1932. Lorsque vous cliquez sur Le Quotidien, vous avez un moteur de recherche qui vous permet de retrouver tous les articles qui ont été publiées. Ces articles sont toujours publiés 8 h 30 heure de l'est, donc heure du Québec et de l'Ontario. Et vous avez la possibilité, il vous est possible d'aller chercher de l'information selon différents indicateurs, et selon certain sujets, et ainsi de suite …

(L'écran survole les hyperliens pour Accueil et sur l'image du drapeau canadien.)

Pendant que vous ouvrez différentes pages. Il est toujours possible de retourner sur la page d'accueil en cliquant sur le bouton Accueil. Lorsque vous ouvrez différentes pages, ou simplement en cliquant sur le drapeau canadien, ou le nom de l'agence à la gauche de notre site Web.

(L'écran passe à la page d'accueil principale.)

Bon avec Le Quotidien è la droite au centre de la page, vous avez « Interagir avec les données », ce qui permet d'avoir accès à des données sur différents formats graphiques.

(L'écran passe à la page d'accueil pour la visualisation des données.)

Vous avez donc la visualisation des données qui présente les données sous forme de graphique. C'est un moyen pratique pour interpréter les tendances qui soustendent nos données liées à diveres sujets sociaux et économiques.

Nous avons les inforgraphies, qui sont en fait des graphiques fixes, mais qui vous présentent les grandes tendances, et les résumés des principales données que nous collectons à Statistique Canada.

(Le pointeur survole l'hyperlien pour les cartes thématiques.)

Et il vous est également possible d'avoir les grandes perspectives géographiques de nos données en cliquant sur certaines cartes thématiques, qui va vous donner une repartition spatiale des données relatives à un theme ou à une géographie particulière.

Et vous avez ensuite une série de vidéos qui vous décrit ce que nous faisons à Statistique Canada, ainsi que certains détails sur nos projets et nos enquêtes statistiques.

Nous allons commander, en haut de la page, cliquer sur encore une fois le drapeau pour retourner à la page d'accueil.

(Le pointeur survole l'hyperlien pour Interagir avec les données.)

Donc un peu plus bas, juste à droite d'Interagir avec les données, vous avez les indicateurs clés.

C'est tout à fait pratique si vous souhaitez chercher une donnée rapide, un chiffre comme l'IPC ou le taux de chômage au Canada.

Vous constatez que le Canada est la géographie par défaut présentée sur la page d'accueil.

Mais c'est données roulantes. Il vous est donc possible de cliquer dessus donc une province ou un territoire de votre choix.

Et vous allez voir que les données sont automatiquement mises à jour avec les données de la province appropriée.

(Le pointeur survole les hyperliens Plus d'indicateurs clés et Tous les indicateurs.)

Il vous est possible d'obtenir plus d'indicateurs clés si vous appuyez sur « Plus d'indicateurs clés » ici. Vous avez donc une série d'indicateurs qui apparaîtront.

Il vous est également possible de voir la totalité d'indicateurs en cliquant ici sur l'icône Tous les indicateurs.

(Le pointeur survole l'hyperlien Services et Information.)

Un peu plus bas sur notre page, encore, Vous avez « Services et information » qui vous permet d'accéder à nos données, de lire nos analyses, de consulter nos ressources documentaires. Bref, c'est 8 hyperliens qui sont exactement les mêmes que vous retrouvez sur la bannière bleue en haut de notre site Web : sujet, données, analyses, référence et géographie pour nommer ceux-là. Vous avez ici données, analyses, ressources, géographies.

Vous avez également 2 autres critères qui pourraient vous intéresser. Nous avons un service de produits et de services personnalisés. Donc vous pouvez contacter un analyste pour avoir des produits qui correspondent à vos besoins spécifiques. Et vous avez également la possibilité de vous inscrire à différents ateliers et conférences qui vous sont proposés par Statistique Canada.

À côté de cette section, vous avez nos principaux produits les plus demandés. Donc vous avez des hyperliens qui vous mènent directement aux tableaux et aux produits les plus demandés. Le profil du recensement, les indices des prix à la consummation, des données sur l'immigration, et sur les estimations de population par exemple.

(Le pointeur survole l'hyperlien Contactez-nous.)

Juste en dessous, vous avez les coordonnées pour l'équipe de Contactez-nous. Nous avons des agents de diffusions qui sont prêts à vous assister si vous avez besoin des données sur notre site Web. Vous avez donc leur numéro de téléphone ici, le numéro sans frais. Il vous est également possible de nous écrire directement de notre site Web en utilisant le formulaire en ligne ou en nous envoyant des courriels à notre adresse juste ici. Veuillez noter que notre bureau est ouvert de 7 h 30 (heure de l'est) jusqu'à 7 h 30, 19 h 30 en fait heure de l'est, encore du lundi au vendredi pour vous assister.

(Le pointeur survole l'hyperlien Ce que nous faisons.)

Un peu plus bas sur notre page d'accueil, vous avez ensuite une section « Ce que nous fesons ».

Donc vous avez des intérêts, des informations supplémentaires sur les recherches et les consultations que nous menons ainsi que les mesures que nous prenons que nous offrons correspondent à vos besoins et respectent les lois sur la statistique et sur la vie, sur la confidentialité des renseignements.

Vous avez enfin une section sur l'organisation elle-même, sur le ministère. Notre mandat, notre structure organisationnelle et ainsi de suite. Ainsi que quelques renseignements supplémentaires sur notre ministre et notre statisticien en chef.

(Le pointeur survole l'hyperlien HUBS.)

Et vous avez finalement en bas de la page, quelques hubs d'intérêts sur des sujets d'actualité qui « collectionent » un peu les différentes nouvelles et nouveaux produits de données qui sont accessibles. Vous avez par exemple, centre de statistiques sur le cannabis.

Vous avez également des statistiques sur le genre, la diversité et l'inclusion.

Donc voici ce qui fait le tour de notre page d'accueil.

(Le pointeur se déplace vers le haut de la page.)

Nous allons passer le reste du webinaire à naviguer le site Web pour obtenir de l'information sous différentes formes.

Nous allons donc commencer par l'onglet « Sujets ».

(La page passe à la page Sujets.)

Donc l'onglet « Sujets » est particulièrement intéressant si vous êtes curieux à propos d'un sujet sans trop connaître les mots-clés ou les types de données que vous souhaitez compiler. Vous avez une trentaine de sujets qui sont listés de façon alphabétique, juste ici. Nous allons voir par exemple vous êtes intéressé à trouver de l'information sur la scolarité au Canada.

Vous pouvez donc sélectionner Éducation, formation et apprentissage.

Et vous allez sur une nouvelle page.

(La page passe à la page Éducation, formation et apprentissage.)

Donc vous avez le sujet qui est résumé en haut de la page. Vous avez ensuite de nouveaux indicateurs clés. Encore une fois le Canada et la géographie par défaut, mais vous pouvez sélectionner différentes provinces. Vous avez des indicateurs qui sont ici et vous avez d'autres indicateurs qui peuvent être fournis si vous appuyez sur la petite fleche à côté de Plus d'indicateurs.

Ensuite vous avez le moteur de recherche qui se trouve sur la gauche du site Web. Il vous est possible de filtrer les résultats par mot-clé. Lorsque vous tapez un mot-clé, la recherche s'effectue autant dans le site que dans la description des produits pour permettre d'avoir les résultats les plus pertinents possible.

Vous avez également la possibilité de faire une recherche par sujet. En fait vous avez sélectionné déjà un premier sujet qui s'appelait éducation, formation et apprentissage.

(Une liste de sous-sujets apparaît.)

Et vous avez une liste de sous-sujets, et de sous-sous-sujets, donc, vous avez jusqu'à un 2e et un 3e niveau de recherche possible par sujet.

Qui vous donne des mots-clés qui pourraient vous aider à accéder l'information que vous recherchez.

Par exemple sur les études postsecondaires, vous avez le nombre de diplômés. Vous avez donc là-dessus.

Au centre de la page donc, vous avez les résultats de notre recherche qui sont affichés. Et il vous est toujours possible de les trier, par défaut, ils seront toujours triés par date.

Sauf si vous faites une recherche par mot-clé qui va vous faire une recherche par pertinence.

Et il vous est également possible de sélectionner une recherche par titre. Dans ce cas là, les produits seront triés en ordre alphabétique de A à Z.

Et aussi de cliquer sur Appliquer pour pouvoir changer le mode de triage.

(On voit la liste de sous-sujets,maintenant trié en ordre alphabétique.)

Vous allez au centre de la page ensuite les différents produits qui sont accessibles pour votre recherche.

Donc au total de la catégorie Éducation, formation et apprentissage, vous avez 1 231 produits qui sont disponibles.

Vous avez les différentes categories de produits. Vous avez les tableaux de données, des analyses et des références.

Okay, il vous est possible de naviguer sur chacun de ces onglets, pour voir quels types de produits nous avons.

Supposons que nous avons, que nous prenons un tableau de données. Vous avez sur la page le titre du produit indiqué ici en haut. Vous avez également son numéro de référence, le numéro de tableau. Vous avez la géographie qui est incluse à l'intérieur de ce tableau et vous avez une description des variables qui sont presentées sur ce produit. Vous pouvez toujours cliquer sur Plus pour obtenir davantage de détails. Et vous avez finalement en bas la date de diffusion du produit.

(Une liste triée par date de diffusion apparaît.)

Donc voilà ce qui conclut un peu la section « Recherche par sujet ».

Nous allons maintenant rentrer un peu plus en détail dans la section Naviguer par données.

Donc depuis le 7 juin nous avons apporté de nombreux changements sur tableaux de données.

Autrefois, nos anciens tableaux CANSIM, nos tableaux sommaires, etc… étaient regroupés dans des environnements séparés.

Donc pour faciliter un peu l'accès à ces tableaux, nous avons donc consolidé et simplifié en les regroupant tous dans l'onglet Données que vous voyez ici.

(Le pointeur survole l'onglet Données.)

Donc vous pouvez constater qu'il y a eu beaucoup de changements. Nous anciens utilisateurs seront peut être un peu confus de voir certaines fonctionnalités qui ont disparues ou qui ont changé. Et il vous est toujours possible de regarder une courte vidéo sur quoi de neuf sur notre site Web.

(Le pointeur passe à la droite et survole l'icône Aide et ensuite survole les mots Quoi de neuf . L'écran passe à la page d'accueil pour une vidéo avec le titre Quoi de neuf sur notre site Web.)

Je vous encourage de la regarder. Nous n'avons pas le temps de le faire aujourd'hui. D'ailleurs une bonne partie de ce qui sera présenté dans la vidéo. sera faite aujourd'hui pendant le webinaire.

Mais ca vous permettra de constaster les principaux changements, et de mieux vous y retrouver sur notre site Web.

(La page passe à la page précédente.)

Donc comme vous pouvez le constater, de la même façon que vous pouviez faire une recherché par mot-clé ou par sujet dans l'onglet « Sujets », vous pouvez également filtrer les résultats par mot-clé. Vous avez également une liste de sujets que vous pouvez étendre en cliquant sur l'onglet « Plus ».

(Le pointeur survole un +.)

Donc vous avez la liste des 31 sujets que nous avions précédement. Vous pouvez également les réduire en cliquant sur l'onglet« Moins ».

(Le pointeur survole un +.)

Vous pouvez également sélectionner une géographie en particulier. Vous avez non seulement les provinces et le Canada, mais également toutes les unites géographiques que nous diffusons, les différentes régions.

Et vous avez enfin, il est possible de faire une recherché par enquête et programme statistique.

(Un tableau de données.)

Donc au centre de la page encore une fois, vous avez des résultats qui sont triés par date, par partinence ou par titre.

Vous pouvez d'ailleurs modifier quels critères vous voulez utiliser pour créer les résultats.

Et vous avez ensuite différents produits qui sont ici, notamment des tableaux.

(Le pointeur survole chacune des colonnes du tableau.)

Donc vous pouvoir ici le 2e tableau, « Banque du Canada, actif et passif, en fin de mois ».

Donc vous avez le titre du tableau ici, et vous avez toujours un numéro de tableau avec un ancien numéro CANSIM.

Donc pour ceux qui avait des favoris sous l'ancien modèle CANSIM, donc par exemple le numéro CANSIM 176-0010.

La plupart de ces tableaux ont été rédirigés dans notre nouveau modèle de diffusion.

Donc vos hyperliens fonctionnent toujours. Il est toujours possible de faire une recherche en utilisant le numéro CANSIM.

Mais vous serez automatiquement redirigé vers le nouveau numéro de tableau et vers le nouveau numéro de diffusion.

Donc vous constaterez que quand vous faites une recherche, si vous ne sélectionnez pas des filtres vous allez vous retrouver avec une masse de documents qui est assez importante. On a 8 055 tableaux et produits de données, dont 7 565 tableaux.

(Un nouveau tableau. Le pointeur survole chacune des colonnes du tableau.)

Si vous descendez en bas, vous constaterez que nous montrons 10 résultats par page et nous avons plus de 756 pages. Donc ça fait beaucoup d'information et la navigation peut vous paraître un peu malaisée. Mais dans ce cas-là, n'hésitez pas de nous contacter. Vous avez nos coordonnées ici. Nous avons des agents de diffusion. qui sont là pour vous assister du lundi au vendredi, 7 h 30 le matin jusqu'à 19 h 30 le soir, heure de l'est. Donc vous serez en mesure d'avoir de l'aide d'un de nos agents qui se fera un plaisir de vous assister.

Donc supposons que vous faites une recherche et qu'un de vos collègues vous demande de trouver de l'information sur le taux d'emploi et le taux de chômage au Québec et en Ontario dans les 3 dernières années. Donc il vous est possible de trouver un tableau de données qui correspond à ces critères. Nous allons donc filtrer les résultats d'abord en utilisant les mots-clés. Nous savons par exemple, que nous voulons chercher des donneés sur l'emploi.

(Nous voyons le mot EMPLOI en cours de saisie dans la boîte de recherche de mots clés et une liste de suggestions.)

Nous allons donc commencer à taper le mot emploi et automatiquement vous allez constater que le système vous fournit des mots-clés qui sont souvent utilisés sur notre moteur de recherche.

(Le pointeur clique sur la première suggestion d'emploi et de chômage et elle apparaît dans la zone de mots clés.)

Nous en avons donc un s'appelle, qui s'intitule « Emploi et le chômage ». Parfait.

Nous allons donc le sélectionner. Et nous allons lancer la recherche à partir, en cliquant sur la loupe juste ici.

(Le pointeur survole l'icône d'une loupe.)

Automatiquement vous allez voir que, un filtre vient d'être ajouté dans la recherche par résultats.

Donc vous pouvez annuler ce filtre en cliquant sur le petit icône, sur le X ici ou en cliquant sur Effacer tous.

Nous allons voir ça dans un instant.

L'avantage des filtres c'est que ca parmet de réduire le nombre de tableaux de données qui sont offerts à vous.

(Le pointeur survole les onglets pour indiquer que le nombre de tableaux a diminué)

Nous sommes passés de près de 8 000 produits et 7 500 tableaux de données à 642 produits et 539 tableaux.

Donc il est possible de réduire ces résultats encore plus.

(Le pointeur passe à la gauche et sélectionne le mot Géographie en face de province et territoires.)

Nous avions mentionné par exemple, que si vous fesiez une recherche sur l'emploi et le chômage pour la province du Québec ou de l'Ontario, il vous est possible d'aller appliquer un filtre géographique.

Pour le sélectionner, il suffit d'aller chercher, de sélectionner la case à côté d'une variable en particulier.

Donc nous allons cliquer sur province, donc vous allez cliquer sur « Province ou territoire » qui comprend 210 tableaux de données.

(Le pointeur survole le tableau)

Et vous voyez donc que le filtre a été automatiquement ajouté ici en haut de la page et se cumule avec le mot-clé « Emploi et chômage. »

Ce qui limite à 210 le nombre de produits et données, donc 208 tableaux.

Et supposons que vous êtes familier avec nos programmes et nos enquêtes statistiques et vous savez, et vous savez très bien que l'Enquête sur la population active est une enquête mensuelle que nous menons qui permet de calculer le taux de chômage et le taux d'emploi au Canada. Et il serait possible d'aller la retrouver en dessous de « Enquête ou programme statistique ».

Elle n'apparaît pas dans les cinq premiers choix, donc vous cliquez sur PLUS pour voir davantage le site, et vous pouvez le voir ici dans la liste alphabétique. Vous avez Enquête sur la population active avec le nombre de produits de données qui sont disponibles avec les filtres que nous avons sélectionnés jusqu'à présent.

(L'écran passe vers le haut de la page.)

Vous sélectionnez donc la table. Vous remontez en haut de la page, et vous voyez donc que nous avons les 3 filtres que nous avons appliqués a permis de réduire le nombre de résultats à 81 tableaux qui est déjà un net avancement.

Il est maintenant possible de trouver un tableau qui répond à vos besoins selon la liste qui vous est présentée au centre du, de la page Web.

Donc pour trouver le tableau de données, je vous suggère d'abord de commencer avec le titre. Nous avons ici « Caractéristiques de la population active, selon la province, données mensuelles désaisonnalisées. »

(Une trame grise apparaît sur le titre du tableau.)

Donc le tableau nous dit déjà que les données sont présentées sous forme mensuelle.

Mais supposons que nous sommes intéressés par un tableau qui donne des données annuelles.

(Le pointeur passe au deuxième résultat.)

Nous allons donc regarder le deuxième tableau proposé,« Caractéristiques de la population active selon le sexe et le groupe d'âge détaillé, données annuelles ». Bon voilà, parfait. Voici un tableau qui nous convient parfaitement.

On peut également lire un peu la description en cliquant sur « Plus ».

(Une description du tableau apparaît dans une fenêtre de dialogue. On ferme la fenêtre.)

Et on voit que le tableau permet de donner des indicateurs sur la population active, le taux de chômage, le taux d'activité et le taux d'emploi.

Donc voici exactement un tableau qui correspond exactement à nos besoins. Pour y accéder, il suffit simplement de cliquer sur le titre du tableau, qui vous amène sur une nouvelle page.

(Un nouveau tableau apparaît. Le pointeur survole différents endroits du tableau.)

Donc voici exactement un tableau Donc lorsque vous arrivez sur le nouveau tableau de données vous avez le titre qui est indiqué en haut et vous avez également la grille d'interprétation qui vous permet d'interpréter les données qui sont exprimé par millier. Ils auraient pu être exprimés en million, ou en milliards si vous êtes sur d'autres types de tableau. Mais si vous savez que les chiffres qui sont présentés dans le tableau doivent être multiplies par millier.

Vous avez également des références et des notes qui sont également accessibles soit dans le tableau, soit ailleurs sur le site Web sous différentes sections.

Et ces notes, supposons que nous en sélectionnons une, vous donnent des précisions méthodologiques sur les différentes variables, les méthodologies que nous utilisons et les concepts et certaines définitions.

Vous avez toujours en dessous du tableau la fréquence qui est exprimée ici de façon annuelle le numéro du tableau, donc le nouveau tableau, dans le nouveau modèle de diffusion ainsi que son ancien numéro CANSIM.

La géographie qui est couverte par le tableau.

Et vous avez également des tableaux connexes et d'autres types de produits qui sont offerts si vous cliquez sur l'hyperlien.

Vous avez également 2 icônes ici, 2 liens qui vous permet d'accéder à une petite vidéo qui montre comment utiliser le tableau de données, mais nous allons les voir, voir ceci ensemble dans les prochaines minutes.

Et vous avez également une liste de questions et réponses qui sont fournies pour comment utiliser les nouveaux tableaux par rapport aux tableaux CANSIM.

Vous avez donc le tableau en lui-même qui présenté ici. Par défaut la géographie va être le Canada.

La première variable est celle de l'emploi. Vous avez les 5 plus récentes periods de référence qui vous sont montrées par défaut. Et vous avez ensuite les différentes caractéristiques : sexe et groupe d'âge des personnes qui sont présentés.

Si vous descendez au bas de la page, vous avez quelques renseignements supplémentaires.

(Le pointeur survole les mots Comment citer le produit.)

Tout d'abord, « Comment citer le produit ». Vous avez le nom de l'agence avec l'hyperlien qui vous amène directement au tableau 14-10-0018-01. Il y a une certaine logique à ces numéros-là. J'en profite pour le dire ici. C'est-à-dire, que les 2 premieres numéros représentent le sujet.

Les deux numéros suivant représentent le type de produit dont il s'agit. Ici le numéro 10 représente un tableau de données.

Les quatre chiffres suivant représentent le tableau multidimensionnel en lui-même.

Et les deux derniers chiffrent représentent la vue disponible pour ce tableau.

La plupart de nos tableaux finissent donc en 01, mais vous avez des tableaux comme l'Indice des prix à la consommation qui peuvent avoir jusqu'à 131 vues différentes.

Ici vous avez également des informations connexes.

Ici vous avez la source ou l'enquête ou le programme statistique duquel les données sont, sont extradites. Ici l'Enquête sur la population active.

(Le pointeur survole une petite flèche.)

Vous avez également des produits connexes. Vous avez simplement à cliquer sur la petite flèche ici pour les ouvrir. Vous avez donc des analyses, des statistiques en bref et d'autres tableaux qui pourraient vous être utiles.

(Une liste apparaît.)

Et vous pouvez également vérifier quelle est la liste de mots-clés qui ont été utilisés pour retrouver ce tableau si vous faites une recherché par sujet.

On va fermer ces informations connexes et on va remonter en haut du tableau.

Donc dans la mise en situation que je vous avais présentée plus tôt, vous cherchiez des données sur le taux de chômage au Québec et en Ontario.

Il vous est possible de modifier le tableau de façon simple en utilisant les menus déroulants que vous trouvez juste ici. Il vous est possible de modifier la géographie et les caractéristiques de la population active.

(Un menu déroulant apparaît. Le pointeur sélectionne le mot Québec.)

Nous pouvons donc cliquer sur l'icône et sélectionner le Québec parmi les provinces qui vous sont offertes.

Vous pouvez faire la même chose pour les caractéristiques de la population active, vous pouvez la voir ici. Et le tableau sera automatiquement mis à jour dès que vous sélectionnez vos variables et que vous cliquez sur le buton bleu « Appliquer ».

(Un nouveau tableau modifié apparaît.)

Donc cette modification simple des éléments du tableau peut se faire rapidment.

Vous avez donc le tableau qui a été modifié pour montrer le Québec, avec le taux de chômage et vous avez la période de référence et vous avez la période de référence qui n'a pas été changée, de 2014 à 2018, avec les mêmes variables de sexe et de groupes d'âge exprimés ici en pourcentage.

Vous avez donc pour les 2 sexes, pour le groupe âgé de 15 ans et plus, le pourcentage au Québec de chômage était de 5,5 % en 2018.

Comme vous pouvez le constater, il est seulement possible d'avoir une caractéristique de la population active et une géographie en même temps si vous utilisez la fonction de modification simple.

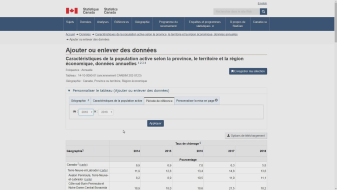

Il vous est possible d'ajouter différentes données des combier si vous utilisez le bouton « Ajouter ou enlever des données » à côté des « Options de téléchargement ».

Donc, supposons que vous cliquez sur cette icône, span vous allez voir une rubrique « Personnaliser le tableau » qui va être maintenant disponible entre le titre du tableau et le tableau lui-même.

(Le pointeur survole les onglets géographie, caractéristiques de la population active, sexe, groupe d'âge et période de référence.)

Vous allez voir qu'il y a plusieurs onglets : géographie, caractéristiques de la population active, sexe, groupes d'âge et période de référence qui sont tous des variables que vous retrouvez à l'intérieur du tableau et que vous pouvez maintenant personnalier.

(Le pointeur survole un hyperlien pour 11 éléments. Le pointeur clique sur l'hyperlien et une liste apparaît. Le pointeur survole un petit cochet vert.)

Donc sélectionnons le premier onglet qui était géographie. Vous voyez que par défaut, 1 de 11 éléments ont été sélectionnés qui correspond au Canada. Vous voyez donc le cochet vert qui est exprimé juste ici. Il vous est possible d'ouvrir la hierarchie des différentes géographies disponibles en cliquant sur le petit triangle noir à côté du carré. Lorsque vous le faites, vous avez automatiquement la sélection des provinces qui viennent s'ajouter juste ici.

(L'écran passe à une nouvelle page et le pointeur survole l'onglet Caractéristiques de la population active.)

Et il vous est donc possible de sélectionner le Québec et l'Ontario à titre de comparaison. Il vous aurait été possible de retirer si vous ne souhaitez pas la voir, mais on va la laisser pour les besoins de la présentation.

Ensuite nous pouvons aller regarder dans les caractéristiques de la population active. Vous avez 1 de 10 éléments sélectionnés. On ne voit pas de cochet vert. C'est simplement parce que la donnée de base est cachée dans l'onglet « population ». Vous pouvez donc cliquer sur la petite icône triangulaire à côté de l'onglet population. Vous allez ensuite dans « population active ». Cliquez encore sur le petit triangle noir et là typiquement vous avez l'emploi qui était sélectionné. Bon ça représente le taux d'emploi, la population active donc le nombre de personnes en emploi.

Vous pouvez le décocher si vous souhaitez avoir seulement le taux de chômage, le taux d'activité et le taux d'emploi. Vous pouvez les sélectionner ici.

Si nous allons maintenant à la variable sexe. Supposons que ça nous convent parfaitement. Nous voulons avoir le total pour les 2 sexes, et nous voulons également pour les hommes et les femmes seulement. On va le laisser tel quel.

(Toutes les variables sont sélectionnées avec des cochets verts et ensuite désélectionnées. Les cochets verts disparaissent.)

Si vous allez dans le groupe d'âge, vous voyez que toutes les variables d'âge ont été sélectionnées. Il vous serait donc possible de sélectionner seulement 15 ans et plus. Vous avez donc l'option de soit déselectionner manuellement toutes les variables qui nous intéressent pas. Ou vous avez une option ici. Le premier, la première case en haut à gauche qui dit « tous sélectionnés » vous permet de tous choisir. Si vous cliquez une fois sur « tous sélectionnés » et si vous recliquez une seconde fois sur la même case, ceci va retirer automatiquement tous les cochets verts qui était dans la sélection. Et vous pouvez maintenant cliquer sur « 15 ans et plus » pour regarder ce que ça dit.

(Un tableau modifié apparaît. La page file vers la droite de l'écran.)

Ensuite, la période de référence. Il vous est possible d'aller chercher des données jusqu'en 1976. Il vous suffit de choisir l'année de départ et l'année de fin. Pour les besoins de la cause, nous avions besoin des données pour les 3 plus récentes années. Nous allons donc aller de 2015 à 2018. Déjà c'est 4 années. Et une fois que vous avez sélectionnées toutes les variables qui vous intéressent il vous suffit de cliquer sur l'icône bleu « Appliquer ». Et le tableau sera automatiquement mis à jour avec les variables sélectionnées.

Comme vous pouvez constater le Canada a été mis ici. Le Québec et l'Ontario ont été rajoutés. Vous pouvez glisser vers la droite le tableau pour voir l'ensemble des données. Et vous avez le taux de chômage, le taux d'activité et le taux d'emploi pour chacune des années sélectionnées, pour les groupes de 15 ans et plus, les 2 sexes, hommes et femmes.

Il vous est possible de manipuler, de changer la mise en page. Supposons que vous voulez un tableau, qui met la géographie sur un axe, sur une rangée qui permettrait de mieux visualiser la vue d'ensemble de toutes ces données. Il vous est possible en cliquant sur l'icône Personnaliser la mise en page, à l'intérieur de la rubrique Personnaliser le tableau du tableau.

(Une nouvelle page apparaît.)

Donc lorsque vous arrivez ici, chacune des variables individuellement peut être exprimée sous forme de colonne ou de rangée. Nous allons donc pour la géographie changer de colonne à ranger.

Et nous allons cliquer sur « Appliquer ».

(Un tableau modifié apparaît.)

Le tableau sera donc mis à jour dans un format facile à lire. Vous avez donc le Canada, le Québec et l'Ontario qui vous permet d'avoir des données, année après année, selon le taux d'emploi, le taux d'activité et le taux de chômage. Maintenant, vous avez un tableau qui correspond aux besoins dont vous, que vous aviez.

Il vous est possible de sauvegarder ce que vous avez fait jusqu'à present de deux façons.

(Une nouvelle page apparaît avec une liste d'options. Le pointeur survole les différentes options.)

La première consiste à enregistrer ma sélection. Vous avez une icône bleue juste en dessous du titre en haut à droite. Quand vous cliquez sur ce bouton, vous avez un hyperlien unique qui vous permet non seulement de sauvegarder le tableau, mais également toutes les variables que vous avez sélectionnées. Ça vous fait un très long hyperlien mais il vous est possible ensuite d'ouvrir une nouvelle page de copier, coller le lien et de le conserver dans vos favoris. Et comme allez pouvoir le constater, le tableau va respecter strictement la mise en forme que vous avez appliquée lorsque vous avez manipulé le tableau pour la première fois.

(Un tableau apparaît.)

Et voilà, vous avez exactement le même tableau et il vous serait possible également de continuer à le modifier et d'en sauvegarder les nouveaux éléments.

(Une nouvelle page apparaît avec une liste de 6 options. Le pointeur survole les différentes options.)

Une autre façon de sauvegarder le tableau serait de télécharger. Vous avez 6 options de téléchargement qui sont fournies ici. Dans le coin supérieur du tableau, vous avez « Options de téléchargement ».

Vous avez un, vous avez six options qui s'offrent à vous. Vous pouvez télécharger la plupart de nos tableaux avec un dossier EXCEL. Vous avez ici le format CSV. C'est le format EXCEL par défaut. Vous pouvez télécharger les données tells qu'affichées, c'est-à-dire après avoir fait une selection de données.

(Le pointeur sélectionne l'option EXCEL et un tableau EXCEL apparaît. Le pointeur survole les différentes colonnes du tableau.)

Vous pouvez également télécharger les données tells qu'affichées, en excluant les symboles qui les accompagnent. Certains de nos tableaux vont fournir des indicateurs de qualités de données, d'une lettre qui va de A à F. Vous pouvez donc avoir des tableaux qui exclueraient ces symbols pour permettre de mieux faire des recherches ou de mieux utiliser les données sur EXCEL.

Vous pouvez également télécharger les données sélectionnées telles que vous les avez manipulés pour le chargement de la base de données. C'est plutôt pratique si vous souhaitez faire une recherche par vecteur. J'irai un plus tôt, un peu plus tard là-dessus.

Vous est également possible d'avoir, de télécharger les métadonnées du tableau ou du cube et vous pouvez également charger le tableau dans son entièreté, y compris les variables que vous n'avez pas sélectionnées. Et vous aurez également les vecteurs qui seront fournis dans le tableau en entier.

Le format SDMX est une initiative internationale. C'est un programme externe qui vous permet de manipuler les tableaux de données qui vous permet sous une forme un peu plus standardisée au niveau international.

Mais la plupart de nos tableaux sont disponibles sous forme EXCEL.

Et nous allons maintenant voir de quoi sera, aura pu voir l'air lorsque vous téléchargez le tableau. Supposons que vous allez télécharger le tableau le tableau tel qu'afficher.

Vous allez avoir un tableau qui va reprendre exactement la même mise en forme que vous aviez sélectionnée.

Vous allez voir le titre du tableau et les données principales qui seront exprimées en haut : la fréquence, le tableau, la géographie.

Vous avez ensuite les données du tableau en elle-même : la géographie, le sexe, le groupe d'âge, le taux de chômage, taux d'activité, le taux d'emploi. Tous les renvois et toutes les références et notes de bas de page sont indiqués ici pour que vous puissiez interpréter les données de façon optimale.

Et vous avez ensuite en bas comment citer le produit avec le numéro de référence et vous avez l'hyperlien qui est fourni dans le tableau EXCEL.

(Le tableau EXCEL est fermé et on retourne à la page avec les options de téléchargement. Le pointeur sélectionne l'option 3 et un tableau apparaît. Le pointeur survole la rangée #2.)

Supposons que vous allez télécharger le tableau pour une base de données, donc l'option 3.

(Le pointeur choisi la colonne K avec le titre « Vecteur » et continue vers la droite et choisi les 6 premières rangées avec la combinaison Canada, taux de chômage, les deux sexes, 15 ans et plus.)

Vous avez non seulement avoir les vecteurs qui sont affichés ici. Un vecteur ce que ça représente, c'est les coordonnées d'un groupe de variables, d'une combinaison de variables spécifiques. Le vecteur que vous voyez ici, donc 2461224, est le vecteur qui correspond à la combinaison Canada, taux de chômage, les deux sexes, 15 ans et plus. Qui est exprimé ici selon une valeur de pourcentage. Donc vous pouvez constater que ce secteur est le même pour toutes ces données, peu importe l'année.

Et vous avez un différent vecteur qui commence ici, qui finit en 434 qui représente le Canada, taux de chômage, hommes de 15 ans et plus. Donc la combinaison de variables a légèrement changé. Le numéro de vecteur va donc changer également.

Il vous est possible de faire une recherche par vecteur. Supposons que c'est vraiment uniquement cette donnée qui vous intéresse et que vous souhaitez la mettre à jour en faisant une recherche sur notre site Web.

(L'écran retourne à la page d'accueil. Le pointeur clique sur Recherche par vecteur.)

Vous allez donc retourner sur la page d'accueil, sur la page de données. Donc nous cliquons sur l'onglet « Données » et il est possible de faire une recherche par vecteur, ici dans le coin supérieur à droite. Si vous cliquez sur « Vecteur », il vous est possible d'utiliser plusieurs vecteurs simultanément.

(On voit la saisie du numéro 2461224 dans le moteur de recherche.)

Nous allons copier-coller celui que nous avons utilisé, le 2461224. Nous allons en rajouter un deuxième, juste par type de référence, donc le v9 pour les estimations de population trimestrielle pour la Nouvelle-Écosse. Et vous pouvez filtrer les résultats par nombre de périodes de référence plus récentes. Vous pouvez donc sélectionner les 3 dernières années.

Nous allons donc taper 3 ici et nous allons lancer la recherche en cliquant sur l'icône « Recherche ».

(Le pointeur sélectionne la boîte à la droite des périodes de référence et le numéro 3 est entré dans le moteur de recherche.)

(L'écran file vers le bas de la page et on voit les résultats. Un nouveau tableau apparaît et le pointeur survole le nom et la description du tableau.)

Et vous allez voir apparaître en bas, le vecteur avec le titre du tableau ci-dessus, la fréquence exprimée, la description, c'est-à-dire les variables contenues par le vecteur : Canada, taux de chômage, les deux sexes, 15 ans et plus. Vous avez l'année de rérérence ici. Et vous avez le pourcentage, exprimé en pourcentage et vous avez la valeur de 7 %. Et vous avez la source ici qui est le numéro du tableau. Si vous désirez vous pouvez directement cliquer là-dessus pour retourner au tableau sur lequel nous étions. Et vous avez la même chose pour différents vecteurs. Et vous pouvez utiliser pour un nombre de périodes multiples et un nombre de vecteurs multiples également.

Et voici ce qui conclut la recherche par données. Nous avons vu coment extraire un tableau de données.

(Le pointeur survole l'onglet Analyse et ensuite l'onglet Données et le moteur de recherche par mots-clés.)

Nous allons maintenant passer à la section Analyse qui correspond à des articles et publications écrites par notre équipe à l'aide des données. Donc ce sont des produits qui contiennent une composant analytique.

(Le pointeur survole les différentes options de recherche.)

Également de la même façon que vous pouvez faire une recherché par sujets ou par données, il vous est possible de faire, de filtrer les résultats par mot-clé, par sujet, par année de publication, par auteur, en ordre alphabétique et par enquête ou programme statistique.

Encore une fois, toujours possible de trier les différents résultats par date, pertinence ou par titre.

Et vous avez ensuite les différents produits qui sont listés ici. Vous avez les Statistiques en bref qui représente des articles courts ou des résumés de données les plus pertinentes.

Ce sont notamment nos articles que vous pouvez retrouver dans Le Quotidien sur notre page d'accueil.

Vous avez des articles et des rapports plus détaillés qui sont fournis ici en plus grand nombre.

(Le pointeur survole les Revues et périodiques.)

Et vous avez finalement des revues et des périodiques qui constituent en fait des collections d'articles et de statistiques en bref. Par exemple si vous cliquez sur cet onglet, nous avons une publication qui s'appelle Juristat qui permet d'avoir accès à des données sur le crime et la justice au Canada. Et si vous cliquez sur cet onglet, vous allez avoir la liste complète de tous les articles par numéro de publication dans les dernières années.

Et il vous est possible une fois de filtrer les résulats par mot-clé pour retrouver que vous pouvez trouver dans le titre du tableau.

(Le pointeur survole la bannière bleue et clique sur l'onglet « Référence ». L'écran change à la page « Référence » .)

Maintenant nous allons passer à la section Référence qui vous permet d'avoir différentes données sur les classifications et les programmes statistiques que nous utilisons. Encore le moteur de recherche est assez similaire.

On peut filtrer par mot-clé, par sujet, par programme statistiques. Vous pouvez trier les résultats encore avec les mêmes icônes.

(Le pointeur clique sur « Classification » et une liste apparaît. Le pointeur survole les « Occupations » et « Industries ». Le pointeur file vers la droite de l'écran et survole les différentes options disponibles.)

Et vous avez différents produits ici : les classifications que nous utilisons les plus couramment. Les enquêtes et les programmes statistiques qui vont contenir des guides et les guides de methodologies sur nos différentes enquêtes.

Vous avez également les fichiers et documentations selon une perspective géographique. Ainsi que quelques avis et consultations qui sont disponibles.

(Le pointeur clique sur Code de classification des industries de l'Amérique du Nord. L'écran passe à une nouvelle page.)

Supposons que vous cherchez le code de classification des industries de l'Amérique du Nord. C'est quelque chose que nous utilisons régulièrement.

Vous pouvez le retrouver parmi nos 13 classifiations. Au numéro 4, vous l'avez ici présent.

Vous pouvez cliquer dessus pour visualiser quels sont les différentes classifications qui sont accessibles. Et vous avez, par exemple, le système de classification de 2017, version 3.0 qui est la version la plus récente mise à jour. Vous avez également l'occasion de vérifier quels étaient les classifications de 2007 et 2017, de 2012, pardon.

Donc voici ce qui conclut la recherche, la navigation par référence.

(Le pointeur survole la bannière bleue et choisi « Géographie ». Une nouvelle page apparaît.)

Maintenant nous allons aborder l'aspect Géographie en cliquant sur l'onglet approprié. Donc l'onglet Géographie a été développé pour aider les utilisateurs à accéder aux données d'une région ou d'une géographie plus spécifique, notamment les municipalités. Donc le nouvel outil de cartographie permet de filter les résultats de toutes les sources de données et couvre tous les sondages et programmes statistiques, y compris les programmes de recensement.

Il vous sera donc possible d'avoir autant les tableaux de données que des produits analytiques, que des produits de référence et les tableaux du recensement.

Vous avez ici le moteur de recherche qui vous permet de chercher par nom de localité ou même par code postal. Et vous avez ensuite en plus bas de la page, chaque fois que vous utilisez un nom de localité, les résultats vont être filtrés. Vous pouvez filtrer par mot-clé, par sujet ou par type encore une fois. Et les résultats vont être régulièrement filters par géographie pour vous montrer les tableaux de données, les analyses et les références qui sont accessibles.

(Le pointeur se déplace vers le nom du lieu ou la case du code postal situé au-dessus de la carte. Les lettres Vanc sont en train d'être dactylographiées. Une liste de 6 suggestions s'affiche. La saisie se poursuit jusqu'à la fin du mot Vancouver et une liste de trois suggestions apparaît. Le pointeur défile à travers les options.)

Nous allons utiliser un exemple. Supposons que vous voulez voir des informations pour la ville de Vancouver. Déjà en tapant les premières lettres de Vancouver, vous voyez plusieurs géographies qui vont sont proposées. Si vous, bien vous avez Vancouver, mais également Vanderhoof, Vanscoy et ainsi de suite. Vous avez également plusieurs choix disponibles. Nous allons finir de taper Vancouver et nous avons encore 3 régions géographiques qui sont proposes. Vous avez la subdivision de recensement qui représente la ville de Vancouver. Vous avez également la region métropolitaine de recensement qui est la plus large géographiquement et qui inclure d'autres divisions. Et vous avez finalement Vancouver qui est le centre de population.

Donc supposons que nous voulons des données sur la ville de Vancouver en elle-même.

(La ville de Vancouver est sélectionnée et une nouvelle carte apparaît et le pointeur survole la carte.)

Donc nous l'avons sélectionné. Nous aurions pu cliquer sur la petite loupe ici. Et vous voyez automatiquement c'est la carte a été mise à jour ici. Pour zoomer sur la géographie sélectionnée.

Vous avez à gauche toutes les géographies connexes qui s'affilie à Vancouver. Vous avez donc les circonscriptions électorales, les divisions de recensment, les régions agricoles, les regions économiques, et la région métropolitaine de recensement pour les données suivantes.

Et automatiquement vous allez voir en bas de la page, tous les tableaux de données, les analyses et les références disponibles pour Vancouver vont être disponible ici. Vous voyez que nous avons 110 tableaux de données qui sont accessibles pour cette géographie en particulier.

Ils auraient également été possible de changer de géographie par exemple en sélectionnant Vancouver pour la région métropolitaine, RMR qui vous permet d'inclure toutes ces données, toutes ces géographies ici.

Et vous voyez et vous constatez que plus la géographie est large, plus le nombre de produits de données accessibles sont nombreaux.

Bon nous allons monter juste un petit peu. Nous allons rester dans l'exemple de la cité de Vancouver, au niveau de la subdivision de recensement. Vous avez donc les circonscriptions électorales.

(Le pointeur clique sur la carte et la carte s'agrandit et une fenêtre s'ouvre à l'intérieur de la carte avec des informations sur l'endroit sélectionné.)

Et il vous également possible de zoomer davantage sur la carte de façon de voir les aires de diffusion.

Vous voyez qu'automatiquement que la carte a été mise à jour et le quadrillage pour toutes les aires de diffusion qui représentent une de nos plus petites circonscriptions géographiques sont maintenant accessibles.

Il vous est possible d'en sélectionner une et vous allez avoir des données concernant les métadonnées, c'est-à-dire le code géographique de la géographie en elle-même et et vous avez également des indicateurs sur la population, le nombre de logements et la densité de population. Comme vous pouvez le constater, plus la géographie est petite, moins est le nombre de tableaux disponibles. Vous en avez également, vous en avez par exemple 16 ici.

(Le pointeur sélectionne l'onglet qui est en-dessous de la carte et on voit une liste de produits reliés.)

Donc voici comment vous pourriez trouver de l'information par géographie, en tapant soit une adresse, un code postal ou un nom de localité en general. Et vous pourriez avoir des tableaux de données qui sont à la fois des tableaux de données, des analyses ou des références.

(Le pointeur passe à la bannière bleue et sélectionne programme du recensement. La page d'accueil du recensement apparaît.)

Nous allons maintenant passer au programme du recensement qui vous permet qui permet d'avoir accès à toutes les données du programme du recensement, qui est plutôt large.

(Le pointeur survole les différents endroits de la page.)

Vous avez d'abord la possibilité de faire une recherche par nom de localité, encore une fois.

Vous avez également des indicateurs clés qui sont disponibles ici. Vous pouvez les maniputer en sélectionnant le menu déroulant, par exemple nous allons à la proportion de, à la variation en pourcentage de 65 ans et plus. Vous avez automatiquement le Canada qui est mis en moyenne en rouge, avec les différentes provinces et territoires qui sont exprimés de façon interactive. Il est encore possible de sélectionner différents indicateurs clés en regardant la liste complète ici.

(Le pointeur survole la section Services et informations à la gauche de l'écran.)

Vous avez également différents services et différents produits de services et informations. Vous avez les produits de données, les produits analytiques et les produits de référence ainsi que des géographies. En bref, vous pouvez donc voir toutes les données du recensement à partir de, de ces icônes-là. À l'exception que le programme du recensement, c'est vraiment une catégorie à part qui va filtrer tous les résultats que vous avez conservée du programme du recensement.

Vous avez quelques tableaux interactifs et les données du recensement de l'agriculture qui sont disponibles.

(Le pointeur file vers le bas de l'écran et survole Recherche par thèmes.)

Enfin il vous est possible de faire une recherche par thèmes. Donc ici vous avez les différents thèmes et sujets qui sont disponibles à l'intérieur du recensement. Par exemple, le travail, le logement, l'âge et le sexe et ainsi de suite. Enfin en bas de la page, vous avez différents liens connexes. Si vous souhaitez avoir de l'information sur les recensements précédents de 1996 à 2011, vous pouvez le faire à partir de cette icône. Vous pouvez également accéder à vos propres renseignements du recensement qui sont confidentiels en suivant l'hyperlien ici près.

(Le pointeur file vers le haut de la page et survole « Trouvez des données ». Le mot Toronto est entré dans le moteur de recherche. Une liste de suggestions apparaît et le pointeur clique sur « Recherchez ». Des résultats apparaîent.)

Si vous montons en haut de la page, nous allons lancer une recherche pour trouver des données. Supposons que nous sommes intéressés par la ville de Toronto. Vous allez voir encore une liste de géographie qui vous est proposée. Il faut simplement cliquer dans la boite et lancer la recherche en cliquant sur l'icône bleue.

Vous allez voir que vous avez différentes géographies qui vous sont proposées ici. Vous avez des subdivisions de recensement, la municipalité de Toronto. Vous avez des regions métropolitaines, des divisions de recensement et ainsi de suite. Si vous n'êtes pas certain de la géographie dont vous avez besoin, si vous ne savez pas la difference entre la RMR de Toronto et la cité de Toronto. vous pouvez toujours visualiser qu'est-ce qui est recouvert comme géographie en cliquant sur le lien carte qui vous permet de voir qu'est-ce qui est inclus dans cette géographie.

(Une fenêtre ouvre et une carte de la cité de Toronto apparaît.)

Voilà la carte est mise à jour et vous savez maintenant que la cité de Toronto représente cette géographie précise. Supposons que cela vous convient parfaitement, vous pouvez cliquer sur« Toronto » Cité juste ici, qui va ouvrir une nouvelle page avec le profil du recensement qui vous permet d'avoir des données sur la population selon différentes caractéristiques et questions que l'on pose dans le recensement.

(Une nouvelle page apparaît.)

(Un tableau apparaît. On fait glisser la barre sur le côté du tableau.)

Comme vous pouvez le constater, il s'agit d'un très long tableau. Si on fait glisser la barre sur le côté du tableau, vous allez voir qu'il y a beaucoup, beaucoup, beaucoup de données.

Donc si vous souhaitez vous renseigner sur un sujet en particulier, vous pouvez remonter en haut du tableau et vous est possible de choisir une vue en particulier.

Donc en dessous du « Profil du recensement », le titre du tableau, vous pouvez choisir une vue. Par défaut, toutes les données vont être montrées, mais vous pouvez sélectionner un tableau en particulier.

(Le pointeur retourne en haut du tableau. ON voit une option Sélectionner une vue. Le pointeur ouvre une liste déroulante et choisi minorités visibles. Le tableau est modifié.)

Un sujet comme « Minorités visibles ». Vous le sélectionnez et vous cliquez sur « Soumettre ». Et le tableau va être automatiquement mis à jour en excluant toutes les données qui ne se rapportent pas à cet, a ce sujet particulier. Le tableau est donc beaucoup plus petit, plus facile à exploiter et vous avez les références et les notes de bas de page, qui permettent d'expliquer les différentes variables en bas du tableau.

(Le pointeur sélectionne changer la géographie et une différente géographie est sélectionnée. Un tableau modifié apparaît.)

Il vous est également possible de combiner différentes géographies. Par exemple vous avez ici la cité de Toronto qui est affichée suite à votre recherche. Et elle est automatiquement comparée avec une division de recensement, ce qui est une unité géographique supérieure. Il vous est possible de changer la géographie en cliquant sur l'icône juste ici. Et vous pouvez utiliser une seconde géographie d'un même niveau. Vous pourriez par exemple comparer avec la ville de Hamilton ou vous auriez pu utiliser, comparer Toronto avec le reste de l'Ontario. Encore une fois, par nom de localité vous cliquez sur « Rechercher ». On va vous proposer différentes options, donc ici pour la province de l'Ontario on n'a qu'une. Et vous avez maintenant le nouveau tableau qui va apparaître avec en première colonne, la ville de Toronto et ensuite la province de l'Ontario juste ici. Pardon. Donc voilà. Ici pour la recherché pour le profil du recensement.

Nous allons retourner sur le « Programme du recensement ».

(La page du programme du recensement réapparaît.)

Le profil du recensement vous permet d'avoir accès à des données uniques, c'est-à-dire que vous allez avoir un chiffre par variable.

Mais il vous est possible de combiner ces variables pour avoir des produits analytiques plus complexes. Pour ce faire, je vous suggère d'aller dans la section « Services et information » sous « Produits de données ».

(La page Services et information réapparaît. Le pointeur survole les différentes options qui paraissent sur la page.)

Nous avons différents produits de données pour vous.

Il y a le profil du recensement, celui que nous avons utilisé. Donc je ne parlerai pas là-dessus. Nous avons différentes faits saillants en tableaux qui sont en fait des informations sommaires par rapport à un thème, à un indicateur clé et à divers niveaux géographiques. Vous avez également des perspectives, une série de perspective géographique qui vous permet d'avoir un accès rapide aux résultats aux différents niveaux de géographie. Vous avez ensuite les tableaux de données qui vous permettent de croiser les différentes variables du, des données du recensement. Vous avez enfin un visualiseur des données du programme du recensement qui est un nouvel outil Web de pointe qui permet de visualiser de façon interactive les données du recensement. Donc je vous suggère. Je vais vous proposer d'aller dans « tableaux des données ».

Et il vous est possible de faire, de parcourir un thème par sujet. Supposons que nous sommes intéressés par des données sur le travail. Nous pouvons donc sélectionner le travail ici.

(Une liste de produits apparaît.)

Et vous avez un total de 87 produits de données qui sont disponibles pour vous sous forme de tableaux. Chacun des tableaux va vous indiquer le type de variable et le nombre de variable associé à chacune d'entre elles dans le titre. Vous avez par exemple la situation d'activité avec 8 variables différentes, la période d'immigration avec 7 différentes variables, le plus haut taux ou certificat, diplôme ou grade obtenu, 7 variables et ainsi de suite.

Vous avez toujours le numéro du catalogue, qui représente le numéro du produit, la géographie couverte ici, et vous avez également 2 formats disponibles. Le format HTML pour visualiser le tableau en ligne.

Et le format B20/20 qui est Beyond 2020, qui est une application externe que vous pouvez télécharger pour mieux manipuler les tableaux de données.

(Le tableau numéro 14 apparaît. Le pointeur survole les différentes colonnes du tableau.)

Supposons qu'après avoir consulté les différents tableaux de données, vous êtes intéressé par le numéro, le tableau numéro 14 qui parle de l'industrie, les revenus d'emploi par rapport à l'industrie. Vous allez donc trouver le tableau qui vous intéresse. Vous pouvez donc le visualiser de façon en ligne sous le format HTML.

Vous avez donc en haut du tableau le titre qui est indiqué ici. Vous avez plusieurs menu déroulants qui permettent de le manipuler. Vous avez donc des variables géographiques, la période de travail travailée, le sexe, la catégorie de travail et l'âge. Et vous avez ensuite le tableau en lui-même avec la géographie par défaut qui est encore Canada, les principales statistiques du revenu d'emploi et l'industrie qui est présentée ici sur le côté gauche. Supposons que vous vouliez des données sur la province du Québec pour les travailleurs autonomes qui ont travaillé pendant toute l'année de référence qui sont de sexe féminin et qui sont âgés de 25 à 64 ans.

Si vous cliquez sur soumettre, le tableau sera automatiquement mis à jour. Et vous avez le total de la population qui correspond strictement aux variables que vous avez sélectionnées. Bon voilà ce qui conclut le survol du programme du recensement.

(La page principale du site réapparaît. Le pointeur survole les différentes options offertes sur la page principale.)

Il est également possible de faire une recherche par enquêtes et par programme statistique. C'est la dernière façon de naviguer notre site Web. Lorsque vous mettez votre curseur en haut, vous avez différentes options : les « Renseignements pour les participants aux enquêtes », les « Résultats et documentations des enquêtes et des programmes statistiques » et vous avez également la « Page principale ».

Si vous sélectionnez la page principale, vous allez retrouver les deux portails différents : pour ceux qui remplissent nos sommaires et nous fournissent des données et vous avez ceux qui recherchent les résultats et des documentations. Si vous cherchez des données, vous devriez donc sélectionner celui-ci.

(Le pointeur survole le moteur de recherche.)

Et si vous ensuite un moteur de recherche similaire qui vous permet de filtrer par mots-clés et par sujet. Les différents programmes et enquêtes statistiques qui sont présentés ici en ordre alphabétique.

(Une nouvelle page est ouverte avec une liste de produits.)

Supposons que vous êtes intéressé par une enquête en particulier, « Activités de loisirs et habitude de lecture ». Vous allez avoir le nombre de produits qui sont listés. Donc ici il n'y a aucune publication. C'est donc un mauvais exemple. Il n'y en a pas ici, mais vous avez de l'information détailée sur les activités de loisirs et habitudes de lecture. Qui va vous emmener sur le portail de l'enquête en elle-même qui a été réalisée en 1978.

(Une liste d'enquêtes apparaît.)

Donc vous avez à la fois des enquêtes qui sont actives et des enquêtes qui sont inactives.

Donc dans ce cas là, vous auriez pu sélectionner une autre enquête et vous auriez obtenu des résultats passablement différents. Voilà ce qui termine un peu la recherche, la navigation sur le site Web.

(La page d'accueil réapparaît.)

Vous avez également À propos de StatCan, qui vous donne quelques renseignements supplémentaires de nous et de ce que nous fesons. Et maintenant j'aimerai avant de conclure j'aimerai retourner sur la page d'accueil pour attirer votre attention sur les séminaires et les webinaires que nous offrons. Nous avons différentes formations et conférences qui sont offertes pour nos utilisateurs.

La plupart sont sur une base de recouvrement coûts, comme les ateliers, mais vous avez également différents webinaires qui sont accessibles auxquels vous pouvez vous inscrire. Donc vous avez une lise complète des webinaires qui sont offerts et vous avez suivi aujourd'hui celui de la navigation sur le site Web de Statistique Canada.

Donc cela conclut notre webinaire pour aujourd'hui pour une durée d'à peu près de 48 minutes.

Donc le webinaire d'aujourd'hui vous a été présenté par le centre de service des données. Nos services donne une aide aux utilisateurs de nos données. Si vous avez des questions sur le webinaire d'aujourd'hui ou tout autre webinaire, n'hésitez-pas de nous appeler ou nous faire parvenir un courriel. Nos coordonnées sont à l'écran. Et vous les retrouver toujours en bas de nos pages web sur le lien compatible.

(Le mot-symbole « Canada » s'affiche.)

- Date de modification :